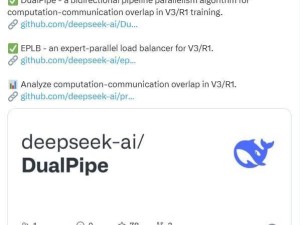

DeepSeek“开源周”活动近日进入尾声,此次活动的焦点之一是公布了一系列优化并行策略的项目。这些项目旨在提升深度学习训练的效率,特别是在V3和R1训练框架中的应用。

其中,“DualPipe”项目尤为引人注目。这是一种创新的双向流水线并行算法,最初在《深度搜索-V3 技术报告》中被提出。通过实现正向和反向计算-通信阶段的完全重叠,并减少流水线气泡,DualPipe极大地提升了训练过程中的资源利用效率。

与此同时,DeepSeek还开源了名为“EPLB”的专家并行负载平衡器。在专家并行(EP)模式下,不同的专家模型被分配到不同的GPU上执行。然而,由于不同专家的负载可能因当前任务而异,保持GPU间的负载平衡成为了一个挑战。为了解决这一问题,DeepSeek采用了冗余专家策略,并开发了一套启发式方法,以确保复制的专家能够合理地分配到各个GPU上,从而实现负载平衡。考虑到DeepSeek-V3中使用的分组受限的专家路由策略,EPLB还尝试将同一组的专家放置在同一节点上,以减少跨节点的数据流量。

为了便于社区复现和部署这一算法,DeepSeek在eplb.py文件中公开了EP负载均衡算法的实现细节。该算法能够根据估计的专家负载,计算出平衡的专家复制和放置计划。当然,预测专家负载的具体方法并不在此次开源的范围内,但通常可以使用历史统计数据的移动平均值作为参考。

除了上述两个核心项目外,DeepSeek还分享了来自其训练和推理框架的分析数据。这些数据涵盖了通信-计算重叠策略以及底层实现细节,旨在帮助社区更好地理解并优化深度学习训练过程。

DeepSeek的这一系列开源举措,不仅展示了其在深度学习并行策略优化方面的深厚积累,也为整个社区提供了宝贵的资源和启示。随着这些项目的逐步推广和应用,我们有理由相信,深度学习训练的效率将得到进一步的提升。