近日,科技巨头meta与斯坦福大学携手,共同推出了一个名为Apollo的全新AI模型系列,这一创新成果在提升机器对视频内容的理解能力上取得了显著突破。

长久以来,尽管人工智能在图像处理和文本分析领域取得了长足进步,但让机器真正“看懂”视频仍然是一个极具挑战性的难题。视频中包含的动态信息错综复杂,处理起来不仅需要强大的计算能力作为支撑,更需要在系统设计层面进行精细化的考量。

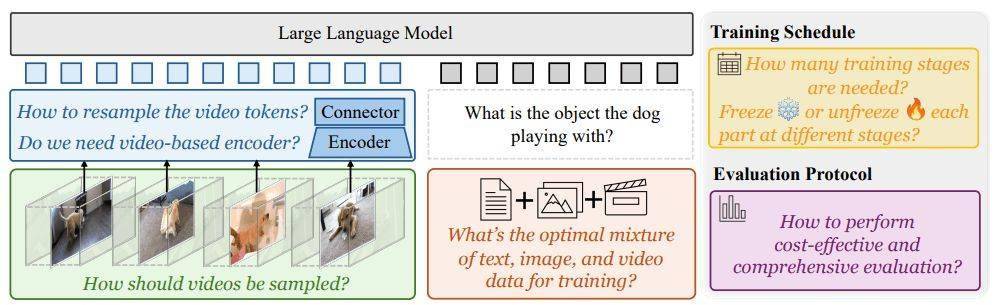

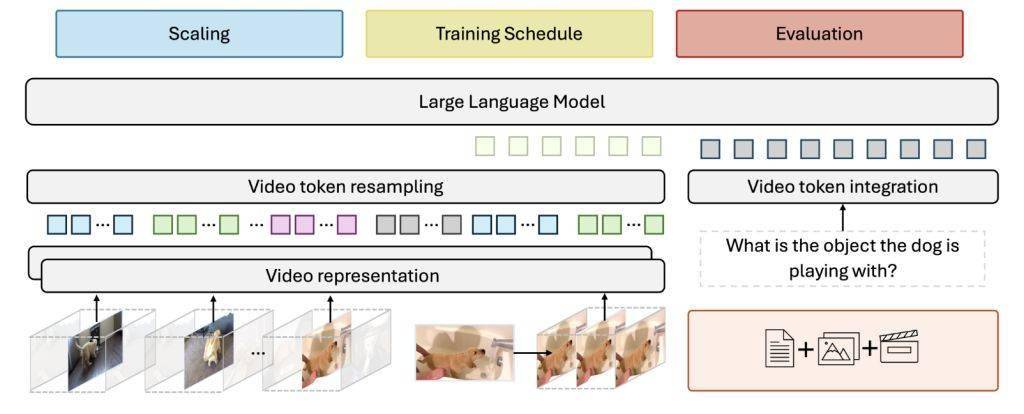

针对视频处理的复杂性,Apollo模型采用了双组件设计。其中一个组件专注于分析单个视频帧的内容,而另一个组件则负责追踪对象和场景随时间的变化。这种设计思路使得Apollo能够更全面地捕捉视频中的信息。

在模型训练方面,meta与斯坦福大学的研究团队发现,训练方法的选择比单纯追求模型规模更为重要。Apollo模型采用了分阶段训练策略,按顺序激活模型的不同部分,这种训练方法相较于一次性训练所有部分,能够取得更好的效果。

研究团队还对数据组合进行了不断优化。他们发现,当数据组合中文本数据占比约为10%~14%,且其余部分略微偏向视频内容时,能够最好地平衡语言理解和视频处理能力。这一发现为Apollo模型的训练提供了有力的数据支持。

Apollo模型在不同规模上均展现出了卓越的性能。其中,较小的Apollo-3B模型已经超越了同等规模的Qwen2-VL等模型,而更大的Apollo-7B模型更是超过了参数更大的同类模型。这一系列成就充分证明了Apollo模型在视频理解领域的领先地位。

为了推动AI技术的进一步发展,meta已经开源了Apollo模型的代码和模型权重,并在Hugging Face平台上提供了公开演示。这一举措将有助于更多开发者和研究人员深入了解Apollo模型的工作原理,并基于其进行更深入的研究和应用开发。