英伟达近期震撼发布了Describe Anything 3B(简称DAM-3B)这一前沿AI模型,专为解决图像与视频中特定区域的精细描述问题而生。该模型在静态图像及动态视频的局部描述领域取得了突破性进展,为相关领域开辟了新的道路。

尽管传统的视觉-语言模型(VLMs)在生成整体图像描述方面已相当成熟,但在处理图像或视频中特定区域的详细描述时却存在明显短板。特别是在动态视频中,时间动态变化、遮挡现象以及区域化描述的需求,使得这一任务变得尤为复杂。DAM-3B的推出正是为了攻克这些难题,它允许用户通过点选、边界框、涂鸦或掩码等方式指定目标区域,进而生成精确且贴合上下文的描述性文本。

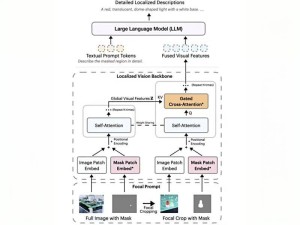

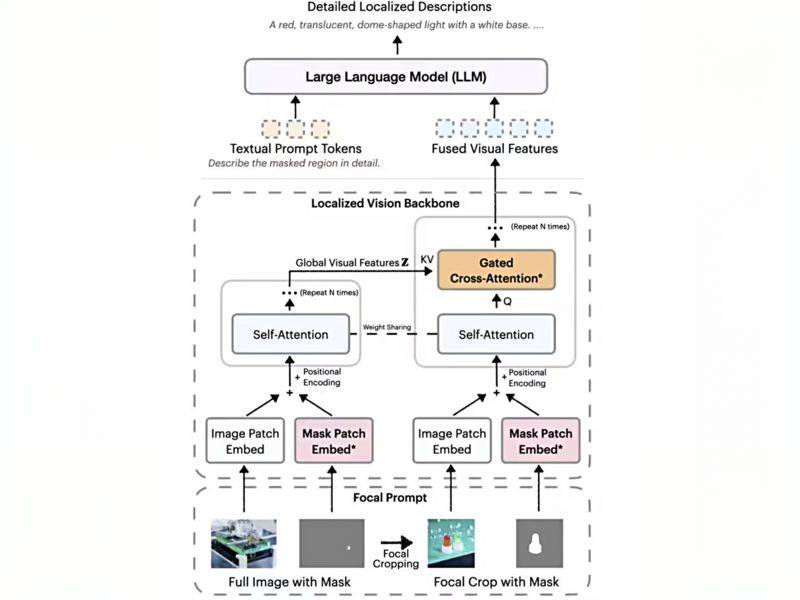

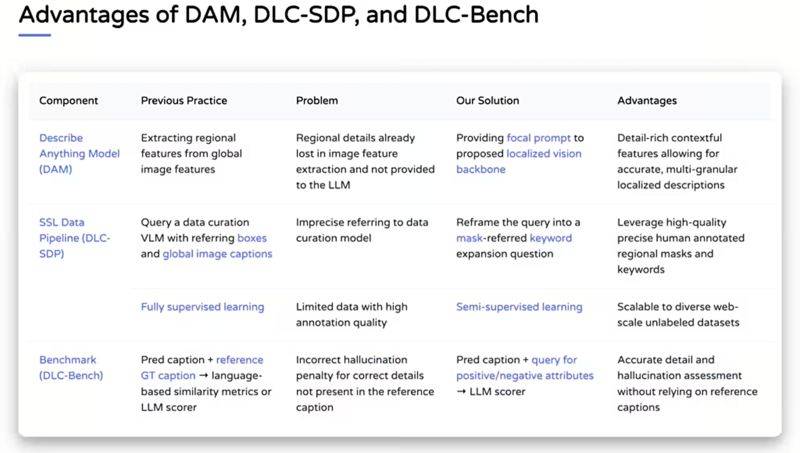

DAM-3B的核心创新在于其“焦点提示”技术。该技术巧妙地将全图信息与目标区域的高分辨率裁剪图相结合,既保留了整体背景,又确保了细节信息的真实呈现。这种独特的融合策略,使得生成的描述更加精确且上下文连贯。

DAM-3B还引入了局部视觉骨干网络。该网络通过嵌入图像和掩码输入,运用先进的门控交叉注意力机制,将全局与局部特征有机融合,再传递给大语言模型以生成描述。这一设计使得模型能够更深入地理解目标区域及其与整体图像之间的关系。

DAM-3B的能力不仅局限于静态图像,其衍生版本DAM-3B-Video更是将这一技术扩展至视频领域。通过逐帧编码区域掩码并整合时间信息,DAM-3B-Video即使在面对遮挡或运动的情况下,也能生成准确的描述,为动态视频的局部描述提供了强有力的解决方案。

为了克服训练数据稀缺的难题,英伟达创新性地开发了DLC-SDP半监督数据生成策略。该策略充分利用分割数据集和未标注的网络图像,构建了包含150万局部描述样本的训练语料库。通过自训练方法不断优化描述质量,确保了输出文本的高精确度。同时,英伟达还推出了DLC-Bench评估基准,以属性级正确性作为衡量描述质量的标准,而非简单地与参考文本进行对比。

在包括LVIS、Flickr30k Entities等在内的七项基准测试中,DAM-3B展现出了卓越的性能,平均准确率达到67.3%,成功超越了GPT-4和VideoRefer等模型,彰显了其在图像和视频局部描述领域的领先地位。