近期,OpenAI的研究团队宣布了一项名为“深思熟虑的对齐”的创新技术,旨在提升人工智能模型的安全性,特别是在大型语言模型(LLMs)领域。这项技术已经在o系列模型中得到了成功应用,并显示出显著的成效。

面对确保大型语言模型遵循道德和安全标准的挑战,现有的对齐技术,如监督微调(SFT)和基于人类反馈的强化学习(RLHF),虽有其优势,但也存在明显的局限。这些技术有时会被恶意提示所操纵,导致生成有害内容、拒绝合理请求或在面对陌生情境时表现不佳。这些问题的根源在于,模型往往是从数据中间接推断安全标准,而非直接学习并理解这些标准。

为了解决这个问题,“深思熟虑的对齐”方法应运而生。它直接教授模型安全规范,并训练模型在生成响应之前,先对这些规范进行推理,将安全原则内化为模型的一部分。这种方法不仅增强了模型的安全性,还提高了其在复杂或对抗性情境下的应对能力。

该技术的实施分为两个阶段。在第一阶段,通过监督微调(SFT),模型学会了参考并推理安全规范,这一过程利用了从基础模型生成的数据集。第二阶段则引入了强化学习(RL),使用奖励模型根据安全基准评估模型的性能,进一步优化其推理能力。值得注意的是,“深思熟虑的对齐”方法减少了对人工标注数据的依赖,而是利用模型生成的数据和思维链(CoT)推理,从而降低了安全训练的资源成本。

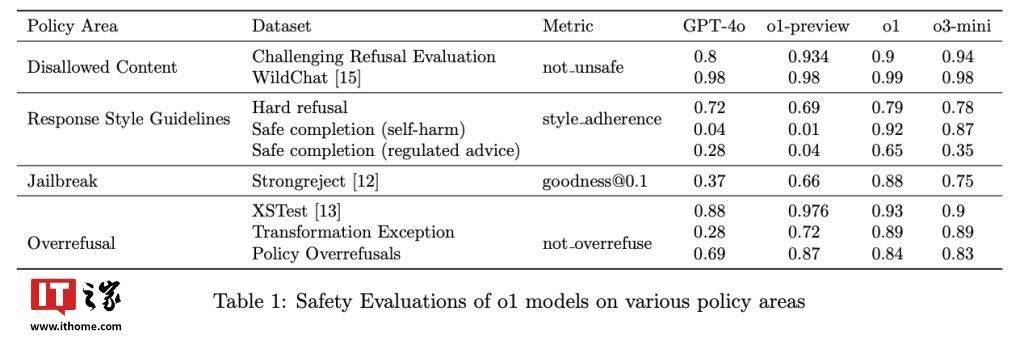

OpenAI的o1模型已经部署了这项技术,并在实际测试中取得了令人瞩目的成绩。在抵抗越狱提示方面,o1模型在StrongREJECT基准测试中的得分高达0.88,远超过GPT-4o的0.37分。同时,这项技术还有效减少了误拒现象,在XSTest数据集的良性提示中,o1模型的准确率达到了93%。

“深思熟虑的对齐”方法通过训练模型明确推理安全策略,为复杂的伦理挑战提供了切实可行的解决方案。这种方法不仅提高了模型的安全性,还增强了其可解释性和可扩展性,为人工智能技术的未来发展开辟了新的道路。